文本挖掘与机器学习跟踪扫描动态快报(2020.05)

实时跟踪、关注文本挖掘与机器学习领域最新研究动态

深度观察

回顾ICLR 2020趋势:

NLP领域更好、更快的Transformer

1.引言

Transformer体系结构最初是在Attention is All You Need中提出的,它是顺序语言建模方法(如LSTM)的有效替代,问世之后在自然语言处理领域无处不在,推动了许多下游任务的发展。 今年的ICLR会议对原始的Transformer及最新的BERT和Transformer-XL进行了许多修订,改进了Transformer众所周知的弱点:

优化了自注意力计算。

在模型架构中注入基于语言动机的归纳偏差。

使模型更具参数和数据效率。

这篇文章希望总结这些针对Transformer的贡献,重点当前趋势。

2.Self-Attention Variants(自注意力变形)

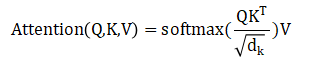

可缩放的点积Self-attention是标准Transformer层中的主要组件之一,无论依赖关系在输入中的距离如何,都可以对其进行建模:

在多头Self-attention变体中,attention功能并行应用于个不同的查询,通过学习的预测投影出的键和值,最后将输出连接起来并再次投影以获得最终值:

本节介绍了Self-attention组件的一些变体:

- 长短距离 Attention

- 具有子树掩盖的树型 Attention

- 超越 Attention

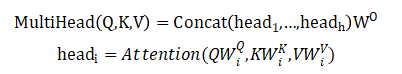

Lite Transformer架构(a)和注意力权重的可视化。传统注意力(b)过于强调局部关系建模(见对角线结构)。通过卷积分支专门化局部特征提取,卷积分支可以有效地对局部进行建模,这样注意力分支就可以专门化全局特征提取(c)。

常规的Self-attention被认为是多余的,因为经验证明它过度强调了句子内部的局部关系。尽管在某些情况下冗余可以帮助对性能进行建模,但它不适用于小体量的应用。

长短距离 Attention(LSRA)可使计算效率更高,该方法将输入沿通道尺寸分成两部分,并将每个部分馈入两个模块中:使用标准Self-attention的全局提取器和使用轻度深度卷积的局部提取器。作者报告称,该模型的整体计算量减少了2倍,使其适用于移动设备设置。

标准Transformer的一个缺点是缺少归纳偏差来解释语言的层次结构。这部分通常是由于递归或递归机制建模的树状结构,难以保持恒定的自我注意时间复杂性。

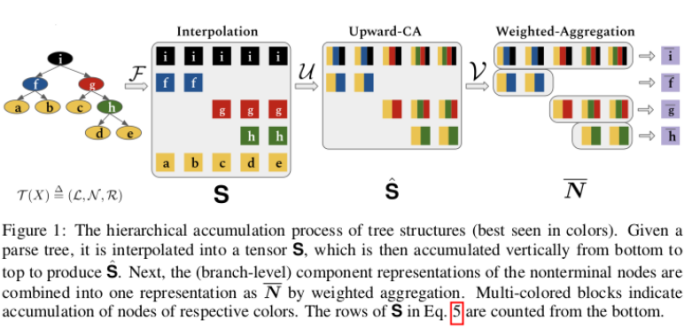

该文所提出的解决方案是利用输入文本的句法分析来构建隐藏状态树,并使用分层累加将非叶子节点的值用子节点聚合来表示。最终的输出表示通过分支级表示的加权聚合来构建。

另一个有趣的想法是将每个节点的查询限制到其子树后代,使用树遮罩来过滤掉多余的噪声。这种归纳偏差的引入会增加计算和存储成本,使用参数共享可以减轻这种成本。

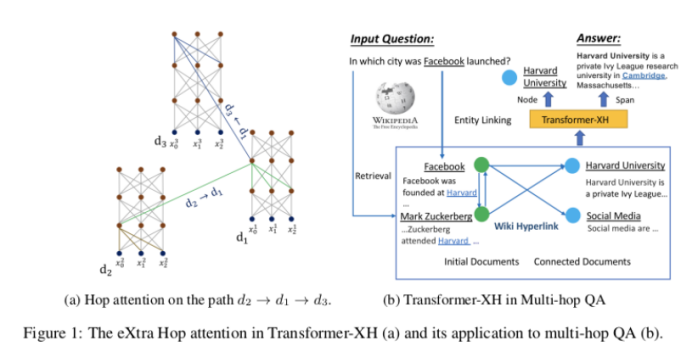

对Transformer进行的优化通常在单个序列或序列对上进行,但这样却很难推广到证据分散在多段文本中的任务,例如多跳问题解答(multi-hop question answering)。

Transformer-XH引入了一种新的注意力变体eXtra Hop Attention,可以将其应用于由边(例如,超链接)连接的文本序列图。这种新的注意力机制将[CLS](每个序列开头的特殊标记)作为关注中心,该中心参与图中的所有其他连接的序列。然后将所得表示与通过线性投影的标准自我注意获得的表示进行组合。生成的模型显示出对需要对图进行推理的任务的显着改进,但以新的注意力机制引入的额外计算为代价。

3.Training Objectives(培训目标)

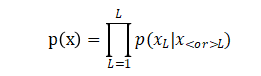

Transformer模型的预训练通常利用大量的无注释文本,通过多个不受监督的目标来实现。用于此目的的最常见任务是自回归语言模型和为掩码语言模型(MLM)。

标准的Transformer及GPT变体采用了自回归方法,利用序列内部的单向上下文(正向或反向)估计下一个token的概率分布:

取而代之的是,类似BERT的方法使用双向上下文来预测被特殊[MASK]替代的输入。事实证明,此变体对下游自然语言理解任务特别有效。

除了单词级建模之外,由于许多重要的语言应用程序都需要理解两个序列之间的关系,因此通常在训练过程中添加诸如下一个句子预测(NSP)之类的句子级分类任务。

尽管这些任务似乎可以诱导有意义的句子层表示,但本节介绍的许多方法都建议使用更好的替代方法,这些方法可以使学习更加有效,并以输入的结构和内容为基础。

- 判别替换任务

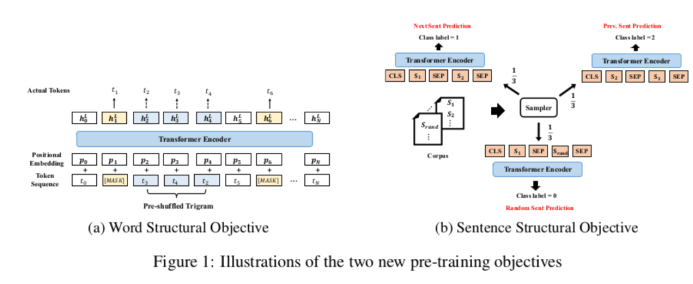

- 词句结构任务

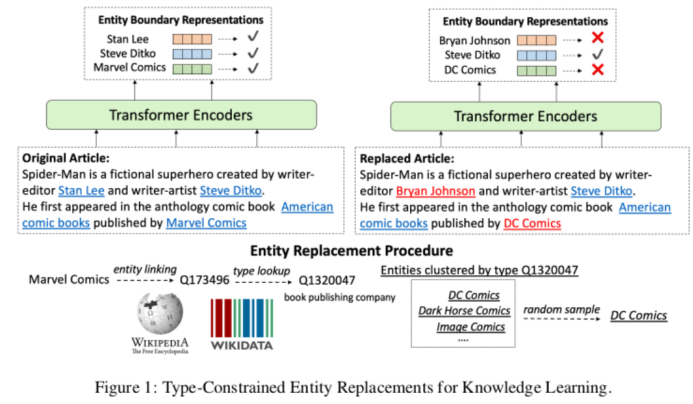

- 具有类型约束的实体替换

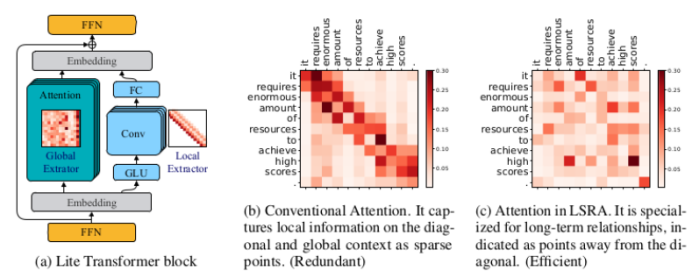

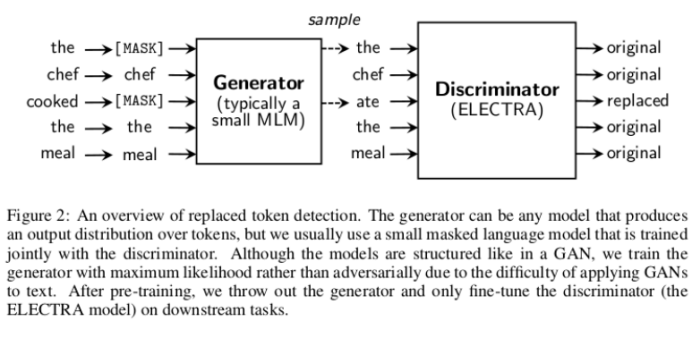

BERT模型中使用的掩蔽策略(MLM)在数据利用上效率很低,仅使用约15%的输入文本来完成MLM任务。但是,由于过多的masked token可能会使整体上下文信息损失严重,因此很难增加屏蔽数据的百分比。

ELECTRA提出了一种简单而有效的方法来应对这种效率低下的问题。像普通的MLM一样,训练一个小的屏蔽语言模型,然后将其用作生成器,用其填充输入中被屏蔽的token。但是,主模型的新任务是一个分类任务:除了预测掩盖的token之外,该模型还必须检测生成器替换了哪些token。这允许利用整个输入序列进行训练,而且在相同的计算预算下,这种方法始终优于MLM预训练。

如前所述,Transformer并未明确考虑输入中存在的结构。StructBERT采用了两种轻便但有效的方法,来了解语言的基本顺序。

第一个是单词结构目标,输入序列中的三元组被随机打乱,必须重新构造其原始位置。这是与常规MLM并行完成的。句子结构目标是ERNIE 2.0中引入的句子重排的一个较轻的变体,与ALBERT中引入的句子重排预测相同:给定句子对(s1,s2),判断s2是否是s1的下一个句子,或上一个句子,或毫无关联的句子(从NSP的0/1分类变成了三分类问题)。这个新任务扩展了标准的NSP。这些增加导致了对自然语言理解的标准基准的重大改进。

尽管已经显示出经过预训练的Transformer模型隐式地捕获了现实世界的知识,但是它们的标准训练目标并未明确考虑到在现实世界中进行可靠推理所需的以实体为中心的信息。

类型约束的实体替换是一种弱监督的方法,其中文本中的随机实体被具有相同实体类型的其他来自Wikidata的实体替换。然后,该模型使用类似于ELECTRA的判别目标来确定替换的实体。这是在多任务设置中与MLM一起完成的,并且作者报告说,在设置方面需要进行重大改进,需要更深入地了解实体。

4.Embeddings(嵌入)

原始的Transformer依靠两组嵌入来表示输入序列:

- 词汇表中存在的每个token的单词嵌入(word embedding)。

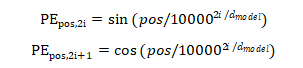

- 固定位置嵌入(position embedding),用于注入有关token在序列中的位置的信息。

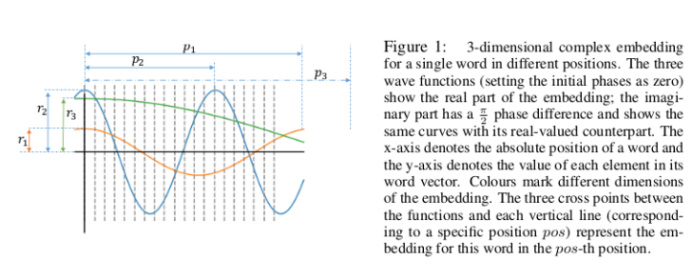

- 位置感知的复杂单词嵌入

- 分解嵌入参数化

对于位置和维度,位置嵌入与正弦周期函数相对应,根据经验显示这些正弦周期函数与通过学习获得的嵌入效果相当:

对于能够在多个输入段上运行的类似BERT的模型,还使用第三组可学习的分段嵌入(segment embedding)来区分属于不同句子的token。

所有这些嵌入都具有相同的尺寸,并被加在一起以获得输入最终的表示。本节介绍的方法旨在给嵌入注入更多结构,或优化其尺寸以提高效率。

尽管PE(position embedding)在输入中捕获了不同的位置,但它们没有明确考虑这些位置之间的关系,即有序关系(例如邻接或优先级)。Transformer-XL已通过利用单词之间的相对距离而不是原始位置索引来解决此问题。

一项建议的改进是将单词嵌入泛化为在位置上定义的连续函数,将解决方案扩展到复数值域,以受益于更丰富的表示形式。生成的复值嵌入为幅度,频率和初始相位引入了新参数,这些参数确定了嵌入的各种属性(例如位置灵敏度)。实验结果表明,具有参数共享方案的复杂嵌入优于以前的嵌入方法,而可训练参数的数量却没有显着增加。

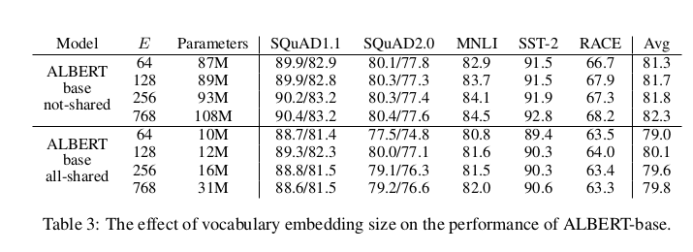

在基于BERT和Transformer-XL的最新模型中,输入嵌入大小e与隐藏层的大小h有关,即e≡h。这是非常不切实际的,因为要增强用于学习上下文相关表示的隐藏层的表达能力,还会同时增加嵌入矩阵的大小m=V×e(此处V是词汇量)。即使对于较小的隐藏层尺寸,也会导致数十亿个参数,这些参数在训练期间很少更新。

ALBERT作者建议在两者之间插入一个投影e和V使两个维度独立,这种方法在h>>e时对于减少参数数量特别有效。从结果来看,一个ALBERT以e=128和 h=768使用较少的21M参数(表3中为89M,而BERT为110M),可以在许多下游任务上获得与具有相同配置的BERT基础相当的性能。

5.Model Architecture(模型架构)

原始的Transformer体系结构由编码器和解码器组成,每个编码器和解码器由相同层的堆叠序列组成,这些序列对具有相同尺寸的输出中的输入嵌入进行转换(因此称为Transformer)。

变压器编码器的每一层都由两个子层,一个多头自我注意机制和一个前馈网络组成,前者会进行残差连接,然后进行层归一化。解码器包括第三层,该第三层对编码器的输出执行多头自我注意,并修改原始的自我注意子层,以防止将来的上下文参加,这是上述自回归语言模型目标所要求的。

Transformer的双向变体放弃了解码器的结构,仅专注于编码器,以生成各种任务(包括MLM)所需的上下文嵌入。

Transformer-XL尤其为Transformer网络引入了一种内存概念,其中在前段中获得的隐藏状态会受到重视,并进行重用以更好地对长期依赖性进行建模,从而防止上下文碎片。

以下方法尝试在当前结构的基础上构建,以改善远程建模,减少参数数量或优化模型执行的计算。

- 压缩存储

- 可逆层

- 跨层参数共享

- 自适应深度估计

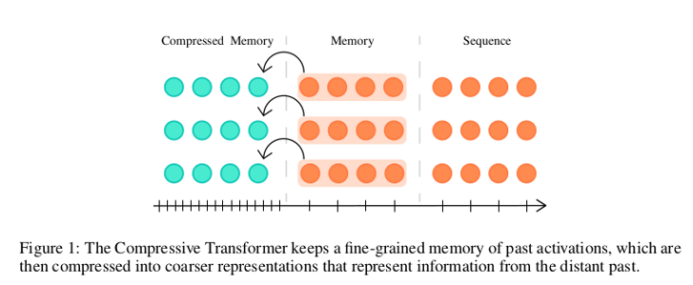

在Transformer-XL的循环存储方法中,旧存储器被丢弃,从而能够以先进先出的方式存储新存储器。此方法仅考虑新近度,而不考虑可能会丢弃的信息的相关性。

压缩Transformer通过添加新的压缩内存(而不是丢弃旧内存的粗略表示)来建立在内存概念的基础上。作者尝试使用多种替代功能来压缩,最后选择一种注意力重建损失,该损失会丢弃网络未参与的信息。压缩内存的使用显示了对不频繁单词建模的巨大改进,并具有网络学习通过压缩机制保留显着信息的经验证据。

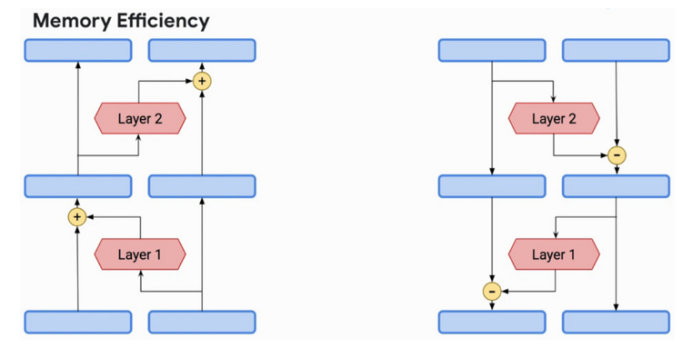

可逆性背后的主要思想是通过仅使用以下层和模型参数的激活来恢复网络任何层中的激活。当应用于Transformer模型时,此功能特别有趣,因为它们通常由一大堆堆叠的层组成,并且它们的内存复杂度随层数线性增长。

通过将注意力和前馈子层组合到单个可逆层中,Reformer在Transformer体系结构中引入了可逆性。这允许仅在最顶层存储激活,并通过在反向传播期间反转各层来恢复所有其他激活,从而使模型深度与存储方式无关。通过在前馈和可逆层中分块独立的计算,可以进一步提高内存的复杂性。

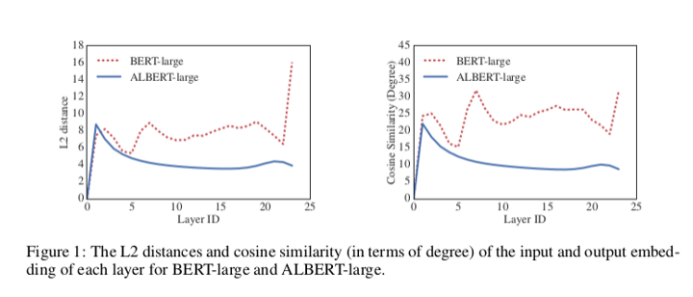

一种简单但非常有效的方法,可以大大减少深度Transformer模型内部的参数数量,即跨层共享参数,正如ICLR 2019在Universal Transformer论文中所展示的那样。

ALBERT作者对Self-attention子层和前馈子层的跨层参数共享进行了实验,发现共享权重矩阵有助于将模型的总参数数量减少两倍,模型大小可以变为原来的七分之一,而对最终效果的影响很小。参数共享的使用可以使跨层的过渡更加平滑,并有效地稳定网络参数。

当前模型为每个输入执行固定数量的计算,而与每个序列特定的基础复杂度无关。这个问题已经在Universal Transformer中得到了强调,Universal Transformer建议使用自适应计算时间(ACT)重复应用同一层,但是由此导致的每层权重的增加大大降低了整体网络速度。

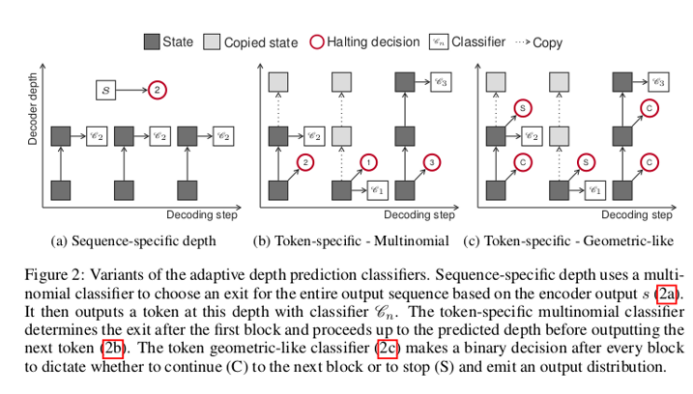

深度自适应Transformer通过使用标准变压器编码器对序列进行编码并以可变步长对其进行解码来解决此问题。为此,将分类器连接到解码器的每个重复层,然后使用首先在计算机视觉领域引入的随时预测方法,通过对齐和混合训练(见图)对整个集合进行训练。

作者探索将任意时刻预测扩展到结构化预测设置中,并引入简单而有效的方法来装备序列模型,以便在网络中的不同点进行预测。作者比较了许多不同的机制来预测所需的网络深度,并发现一个简单的基于正确性的类几何分类器在速度和精度之间取得了最佳的平衡。结果表明,与经过调优的Transformer基线相比,解码器层的数量可以减少四分之三以上,并且不会损失精度。。

5.结论

在ICLR 2020上引入的许多方法为特定问题的解决提供了广泛适用的方案,这些问题是原始Transformer体系结构的特征,范围从自注意力计算到模型结构本身。

这些方法中的许多方法似乎对Transformer的未来发展很有希望,而且最重要的是,一旦其中许多方法包含在单个体系结构中,它们就有可能带来互补的改进。

(张梦婷编译,李朝安校对)

研究动态

利用NLU驱动的工具来探索有关COVID-19的科技文献

由于COVID-19的传播,世界各地的科学家和研究人员正在进行大量的新研究,以了解和抗击该疾病。尽管研究量令人鼓舞,但科学家和研究人员很难跟上最新研究成果的快速迭代。传统的搜索引擎可以为一般的COVID-19问题提供实时有效的信息,例如“在美国目前有多少COVID-19个病例?”,但难以理解驱动查询背后的目的。此外,使用基于关键字的传统方法搜索现有的COVID-19科技文献语料库,很难给该复杂查询找到相关的线索。

为了帮助解决此问题,我们将在COVID-19开放研究数据集(CORD-19)之上启动COVID-19研究浏览器,即语义搜索界面,其中包括50,000多种期刊文章和预印本。我们设计该工具的目的是帮助科学家和研究人员有效地浏览有关COVID-19相关问题的答案或线索的文章。

当用户提出初始问题时,该工具不仅会返回一组论文(例如在传统搜索中),而且还会突出显示可能是该问题答案的论文摘要。用户可以查看这些摘要,并迅速决定该论文是否值得进一步阅读。如果用户对最初的论文和摘录集感到满意,我们就将该问题将作为对原始检索文章集的新查询。我们希望这些功能能促进知识探索和科学假设证据的电子收集。

- 语义搜索

- 混合项-神经检索模型

- 可用性和社区反馈

支持该工具的一项关键技术是语义搜索。语义搜索的目的不仅是捕获查询和文档之间的术语重叠,而是要真正理解短语的含义是否与用户查询背后的真实意图有关。

如果你查询“什么调节ACE2表达?”即使这看起来像是一个简单的问题,某些短语仍可能使仅依赖于文本匹配的搜索引擎感到困惑。例如,“调节”可以指许多生物学过程。尽管传统的信息检索(IR)系统使用诸如查询扩展之类的技术来减轻这种混淆,但语义搜索模型旨在隐式学习这些关系。

单词顺序也很重要。ACE2(血管紧张素转换酶2)本身可调节某些生物过程,但问题实际上是在问什么对ACE2进行调节。仅按术语进行匹配并不能区分“什么调节ACE2”和“什么ACE2调节”。传统的IR系统会使用“词义匹配”之类的技巧,但是语义搜索方法则力求在其核心上对单词顺序和语义进行建模。

我们使用的语义搜索技术由BERT支持,以提高Google搜索的检索质量。对于COVID-19 Research Explorer,我们面临的挑战是,生物医学文献使用的语言与提交给Google.com的查询的语言完全不同。为了训练BERT模型,我们需要监视进程——查询及其相关文档和摘要结果示例。尽管我们依靠BioASQ产生的出色资源来进行微调,但此类人为整理的数据集往往很小。神经语义搜索模型需要大量的训练数据。为了扩充小型的人为构造数据集,我们利用一系列查询来构建生物医学领域的大型综合问题集和相关文档。

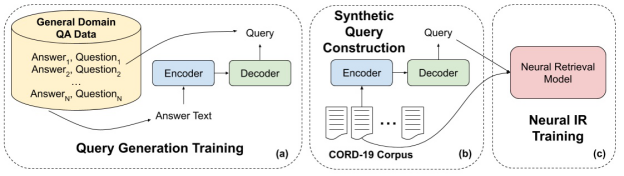

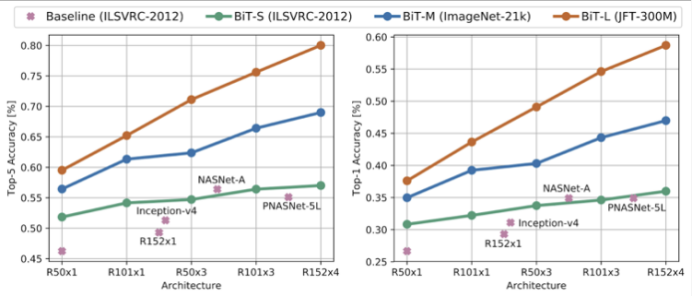

具体来说,我们使用了大量的通用领域问答对来训练编码器-解码器模型(在下面的图中,a部分)。这种神经体系结构用于诸如机器翻译之类的任务中,该任务对一个文本片段(例如英语句子)进行编码,并生成另一文本片段(例如法语句子)。在这里,我们对模型进行了训练,以将答案段落转换为关于该内容的问题(或疑问)的模型。接下来,我们从集合中的每个文档(在本例中为CORD-19)中获取段落,并生成了相应的查询(b部分)。然后,我们使用这些综合查询-通道对作为监视来训练我们的神经检索模型(c部分)。

图1 综合查询构造

但是,我们发现在某些示例中,神经模型的性能要比基于关键字的模型差。 这是因为主题化-泛化连续体,它在大多数人工智能和心理语言学领域中众所周知。基于关键字的模型(如tf-idf)本质上是一种记忆。它们存储查询中的术语,并查找包含这些术语的文档。另一方面,神经检索模型学习有关概念和含义的概括,并尝试根据这些概念和含义进行匹配。有时,当精度很重要时,它们可能会过度概括。例如,如果我查询“什么调节ACE2表达?”,则可能希望该模型推广“调节”的概念,而不是ACE2的缩写。

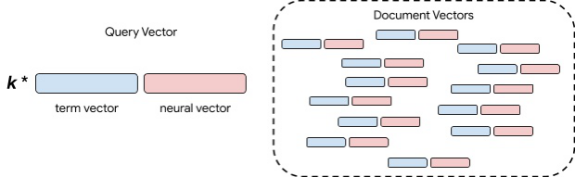

为了改善我们的系统,我们建立了一个混合的术语-神经检索模型。其关键是基于术语的模型和神经模型都可以转换为向量空间模型。换句话说,我们可以对查询和文档进行编码,然后将检索作为对待与查询矢量最相似的文档矢量进行处理,也就是最近邻居检索。要进行大规模这项工作,需要进行大量的研究和工程设计,但它使我们能够采用简单的方法来组合各种方法。最简单的方法是将向量与权衡取舍参数相结合。

图表 2 混合术语和神经检索

在上图中,蓝色框是基于术语的向量,红色框是神经向量。我们通过串联这些向量来表示文档。我们也将这两个向量串联在一起进行查询,但是我们控制了精确术语匹配与神经语义匹配的相对重要性。这通过权重参数k完成。尽管可能有更复杂的混合方案,但我们发现,这种简单的混合模型在我们的生物医学文献检索基准上显着提高了质量。

COVID-19 Research Explorer作为open alpha免费提供给研究社区。在接下来的几个月中,我们将进行一些可用性增强,因此请经常回来查看。试用COVID-19 Research Explorer,然后通过站点上的反馈渠道与我们分享您的任何意见。

致谢

由于许多人的辛勤工作,这项努力取得了成功,其中包括但不限于以下各项(按姓氏字母顺序排列):John Alex,WaleedAmmar,Greg Billock,Yale Cong,Ali Elkahky,Daniel Francisco,Stephen Greco, StefanHosein,Johanna Katz,Gyorgy Kiss,Margarita Kopniczky,Ivan Korotkov,Dominic Leung,Daphne Luong,Ji Ma,Ryan Mcdonald,Matt Pearson-Beck,Biao She,Jonathan SheR,Kester Tong,Ben Wedin。

(李朝安编译,王宇飞校对)

通过数据回传加速神经网络训练

2019年10月,澳大利亚墨尔本的一名亚马逊员工在骑自行车的路上撞上了一个人。当她向那个人保证她会帮忙时,她意识到他是聋哑人,不知道他在说什么。

如果有辅助技术来促进双方的沟通,这种尴尬局面本可以避免。事件发生后,亚马逊网络服务(Amazon Web Services)东南亚技术主管Santanu Dutt领导的一个团队开始工作。

在10天左右的时间里,Dutt的团队建立了一个用手语训练机器学习模型。通过使用从相机上拍摄的手势语手势的图像,该模型可以识别手势并将其转换为文本。该模型还可以将口语转换成文本,供聋哑人阅读。

Dutt说,随着机器学习服务和应用程序接口(API)的出现和开放,该模型还可以定制为将语音转换为手语——尽管他还没有看到这种需求。但仍有需要改进的地方:由于训练是在白色背景下用手势进行的,因此在实际使用中,目前形式的模型的效果将受到限制。

Dutt团队展示这一点的时间有限,但他们希望能拿出一些东西来展示,用于实验目的。企业可以使用Amazon SageMaker等工具,用更多的图像和视频来编辑和训练模型,以识别更大范围的环境。这也将有助于提高模型的准确率。事实上,拥有的数据越多,模型就越精确。开发人员可以设置置信水平,并拒绝低于某一准确水平的结果。

Dutt表示,AWS的公共部门团队已经与澳大利亚的非营利组织进行了合作,以利用机器学习模型来进行概念验证,以抵销使用AWS服务进行训练和部署该模型的成本。

(张梦婷编译,王宇飞校对)

开源BiT:探索计算机视觉的大规模预训练

现代深层神经网络总是渴望得到更多的标记数据——目前最先进的CNNs需要在诸如OpenImages或Places这样的数据集上进行训练,这些数据集包含超过1百万个标记图像。事实上,收集如此庞大规模的数据是困难的。而缓和计算机视觉任务中标记数据不足问题一种常见方法是使用经过通用数据(如ImageNet)预训练的模型。其思想是,在通用数据上学习到的视觉特性可以重新用于感兴趣的任务。尽管这种预训练在实践中相当有效,但它仍然缺乏快速掌握新概念并在不同背景下理解新概念的能力。类似于BERT和T5在语言领域的进步,我们认为大规模的预训练可以提高计算机视觉模型的性能。

在“Big Transfer(BiT):一般视觉表征学习”中,我们设计了一种方法,可以使用超出实际标准规模的图像数据集(ILSVRC-2012)进行有效的一般特征预训练。在训练数据规模很大的情况下,适当选择规范化层和缩放体系结构容量是极为重要的。

苹果和谷歌将在五月中旬引入一对iOS和Android的API,并确保这些卫生部门的应用程序能够实现它们。在此阶段,用户仍必须下载应用程序才能参与联系人跟踪,这可能会限制采用率。但是在API完成后的几个月内,两家公司将致力于在基础操作系统中构建跟踪功能,使此功能作为每个使用iOS或Android手机的人都可以立即使用的选项。

- 预训练

- 迁移学习

- 使用ObjectNet进行评估

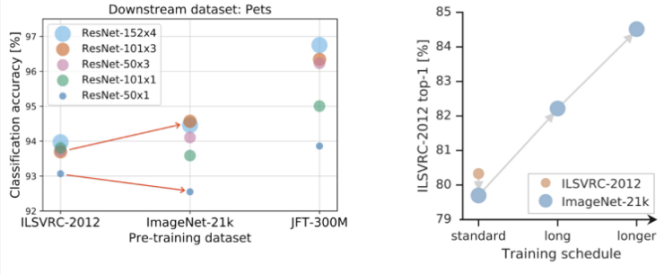

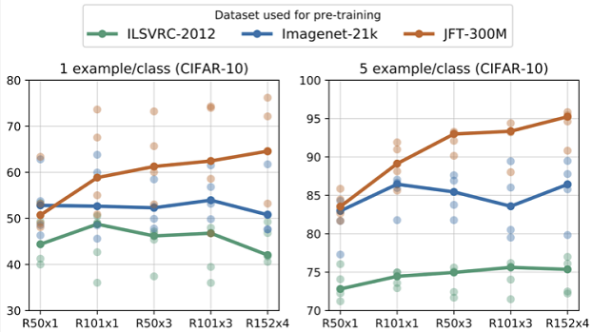

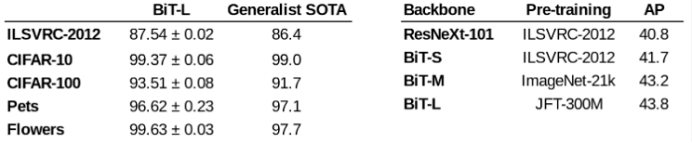

首先研究的是数据集大小和模型容量之间的关系。利用经典的ResNet架构,在ILSVRC-2012(1.28M)、ImageNet-21K(14M)和JFT(300M)这三个数据集上,分别训练了从标准的50层深的“R50x1”,到4倍宽、152层深的“R152x4”的变体。一项主要的观察结果是,若想在更大的数据集上获得更好的训练效果,就需要增加模型容量。

研究发现训练时间至关重要。如果在较大的数据集上进行预训练而不调整计算预算和训练时间,那么性能可能会变得更差。然而,通过使时间表适应新的数据集,改进可能会很显着。

此外,用群规范化(GN, group normalization)代替批规范化(BN, batch normalization)也是有利于大规模训练的。首先,BN的状态(神经激活的均值和方差)需要在预训练和迁移之间进行调整,而GN是无状态的,因此避开了这一困难。第二,BN使用批处理级别的统计数据,大型模型不可避免地出现小设备(small per-device)批处理量,BN就会变得不可靠。由于GN不计算批处理级别的统计数据,因此它也回避了这个问题。

遵循BERT在语言领域建立的方法,我们针对来自各种“下游”任务的数据(可能带有很少的标记数据)微调了预训练的BiT模型。由于预先训练的模型已经对视觉世界有了很好的理解,所以这个简单的策略非常有效。微调涉及大量超参数,例如学习率、权重衰减等。研究人员提出了一种启发式的方法来选择这些超参数,称之为“BiT-HyperRule”。该方法仅基于高层次的数据集特征,例如图像分辨率和标记实例的数量。

当用很少的例子将BiT转移到任务时,随着同时增加用于预训练的通用数据量和体系结构容量时,生成的模型适应新数据的能力显著提高。

为了验证这个结果是否具有普遍性,研究人员在VTAB-1k上进行了实验。VTAB-1k是由19个不同任务组成的任务套件,每个任务只有1000个标记示例。BiT-L模型(在JFT-300M上进行预训练)迁移到这些任务上后,获得了76.3%的总得分,比此前的SOTA方法提高了5.8%。

另外,BiT-L在标准CV基准Oxford Pets、Flowers、CIFAR上的结果也表明,这种大规模预训练和简单迁移的策略在数据量适中的情况下也是有效的。在MSCOCO-2017检测任务中使用BiT作为RetinaNet的骨干,发现即使对于这样一个结构化的输出任务,使用大规模的预训练也有相当大的帮助。

为了进一步评估BiT的鲁棒性,研究人员还在基于真实照片的ObjectNet数据集上对模型进行验证。BiT-L模型的top-5精度刷新记录,达到80%,比此前的SOTA方法提高将近25%,这使得数据和架构规模的好处更加明显。

(张梦婷编译,王宇飞校对)

近期论文

Summarization An Empirical Study of Multi-Task Learning on BERT for Biomedical Text Mining

(多任务学习的BERT在生物医学文本挖掘上的的经验研究)

Yifan Peng Qingyu Chen Zhiyong Lu

摘要

多任务学习(MTL)已经在自然语言处理的应用中取得了显著成就。在本文中,我们研究了具有多个解码器的多任务学习模型,该模型针对多种生物医学和临床领域的自然语言处理任务,例如文本相似性、关系提取、命名实体识别和文本推理。我们的经验结果表明,在生物医学和临床领域,经过微调的MTL模型分别优于最新的变压器模型(例如BERT及其变体)2.0%和1.3%。Pairwise MTL进一步展示了哪些任务可以改善或降低其他任务的效果。在研究人员为新问题选择合适的模型中,这将非常有用。该代码和模型可在https://github.com/ ncbi-nlp / bluebert上公开获得。

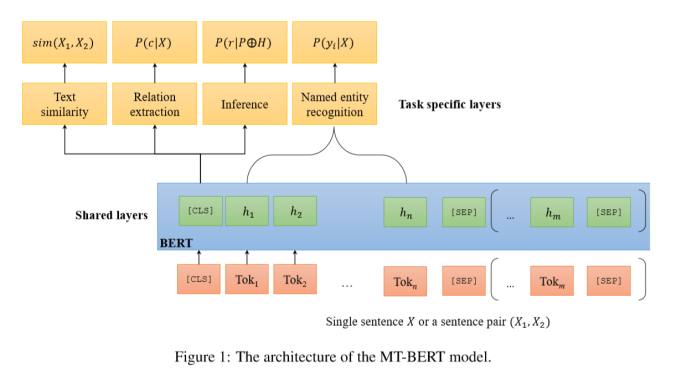

模型结构

模型结构如下图所示,共享层是基于BERT的结构。输入X可以是一个句子,也可以是一对句子,用[SEP]分割。在共享的BERT层之上,是针对特定任务的全连接层。在训练阶段,使用多任务的目标微调BERT模型和全连接层。

多任务目标

1. 句子相似度

假设h0是输入句子对(X1,X2)中[CLS]的输出。可以使用一个全连接层来计算相似性分数sim(X1,X2)=ah0+b。使用均方误差(MSE)损失训练该任务。

2. 关系提取

此任务使用预定义标签替换两个句子中的关系后,可以将该任务视为单个句子的分类问题。假设h0是[CLS]的输出嵌入,关系被标记为c类的概率是通过全连接层和softmax进行logistic回归预测的:P(c|X)=softmax(ah0+b),并使用绝对交叉熵损失训练该任务。

3. 文本推理

将一对带有假设的前提句子打包成一个序列后,该任务也可以视为单个句子的分类问题。目的是找到前提P和假设H之间的逻辑关系R,即假设h0是[CLS]在X=P⊕H,P(R|P⊕H)=softmax(ah0+b)条件下的输出嵌入,使用分类互熵损失来训练此任务。

4. 命名实体识别

BERT模型的输出会生成特征向量序列,其长度与输入序列X相同。MTL模型通过使用softmax输出层来预测标签序列,使用绝对交叉熵损失训练该任务。

模型训练

包含三个阶段,预训练BERT模型;通过多任务学习对其进行优化;使用特定领域的数据进行微调。

1.预训练:使用BERT-base,最长序列长度为128。

2.多目标优化:这一步优化模型中的所有层。首先使用预训练的BERT模型初始化共享层,并随机初始化特定任务层的参数。然后,通过合并所有数据集的迷你批次来创建数据集。在每个epoch,都从所有数据集D中随机选择任务t的小批次数据。最后,根据任务t的任务特定目标更新模型。使用基于小批量的随机梯度下降来学习参数。

3.微调:对在上一阶段接受训练的MT-BERT进行微调,继续对每个特定任务进行所有层的训练,假设该数据集在上下文上与其他数据集没有太大不同,则MT-BERT模型已经学习了与特定问题相关的一般特征。具体来说,实验截断MT-BERT的最后一层(softmax和线性层),并用新层替换它,然后使用较小的学习率来训练网络

实验结果

在BLUE基准测试中针对8个任务评估了MT-BERT,比较了三种类型的模型:(1)分别在每个任务上直接微调BERT的模型;(2)通过多任务训练改进MT-BERT;(3)具有微调功能的MT-BERT(MT-BERT-Fine-Tune)。

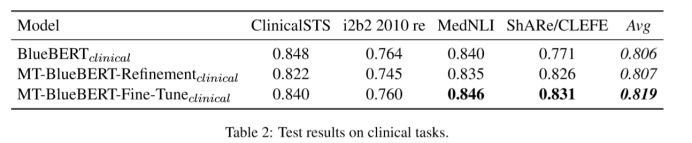

下表展示了在临床任务中的结果。MT-BlueBERT-Fine-Tuneclinical在2个任务上取得了最高的得分,并将基准提高到81.9%,与BlueBERTclinical相比,绝对值提高了1.3%。

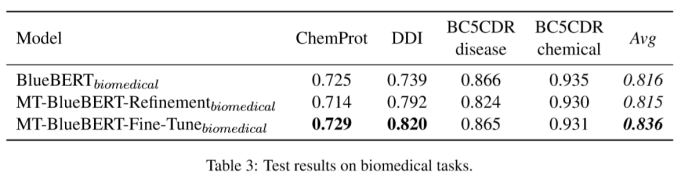

下表展示了在生物医学任务中的结果。实验使用BlueBERTbiomedical作对比,因为它在BLUE基准测试中获得了最佳性能。MT-BlueBERT-Fine-Tunebiomedical在2个任务上取得了最高的得分,将基准提高到83.6%,与BlueBERTbiomedical相比提高了2.0%。

(王宇飞编译,李朝安校对)

近期会议

JCDL 2020: Joint Conference on Digital Libraries

June 19 - June 23 ,2020 陕西 西安

数字图书馆联合会议(JCDL)是一个重点讨论数字图书馆及其相关的技术实践以及社会问题的国际论坛。JCDL通过将ACM数字图书馆会议和IEEE-CS数字图书馆会议的进展结合起来,加强了ACM和IEEE-CS已经建立的会议卓越的传统。在本次会议上,JCDL向在该领域做出杰出贡献的人士颁发Vannevar Bush最佳论文奖、最佳学生论文奖、最佳国际论文奖、最佳海报奖。该会议邀请国家和国际社会就数字图书馆感兴趣的广泛主题发表论文。

2020 ASIS&T Asia-Pacific Regional Conference

Jun24 – Jun25, 2020 湖北 武汉

https://www.asist.org/chapters/asiapac/events/2020-regional-meeting/

国际信息科学与技术学会(ASIS&T,Association for Information Science and Technology)是目前图书馆情报学、信息技术、信息管理等领域最具学术影响力的国际学术组织之一。出版有JASIST、Bulletin of the ASIS&T等专业刊物,每年举办年度大会及相关主题峰会。